La compagnia cinese DeepSeek ha sconvolto il mercato dell’IA (e la Borsa americana) con il lancio del suo modello R1 la scorsa settimana. Un documento di ricerca pubblicato in occasione del lancio ha rivelato che DeepSeek ha speso solo 6 milioni di dollari in potenza di calcolo per ogni sessione di addestramento del modello, un costo inferiore rispetto a quanto stimato (e in parte confermato) per IA popolari come ChatGPT o Gemini di Google. Questo nonostante il fatto che, dal suo debutto il 20 gennaio, DeepSeek-R1 abbia ottenuto buoni risultati in termini di prestazioni, rivaleggiando con concorrenti più grandi.

I chip per computer di fascia alta, come quelli prodotti da Nvidia, sono fondamentali per sviluppare ed eseguire grandi modelli di IA. Tuttavia, questo nuovo sviluppo dimostra che è possibile ottenere risultati di qualità anche con un budget inferiore e un minor numero di chip o con hardware meno avanzato.

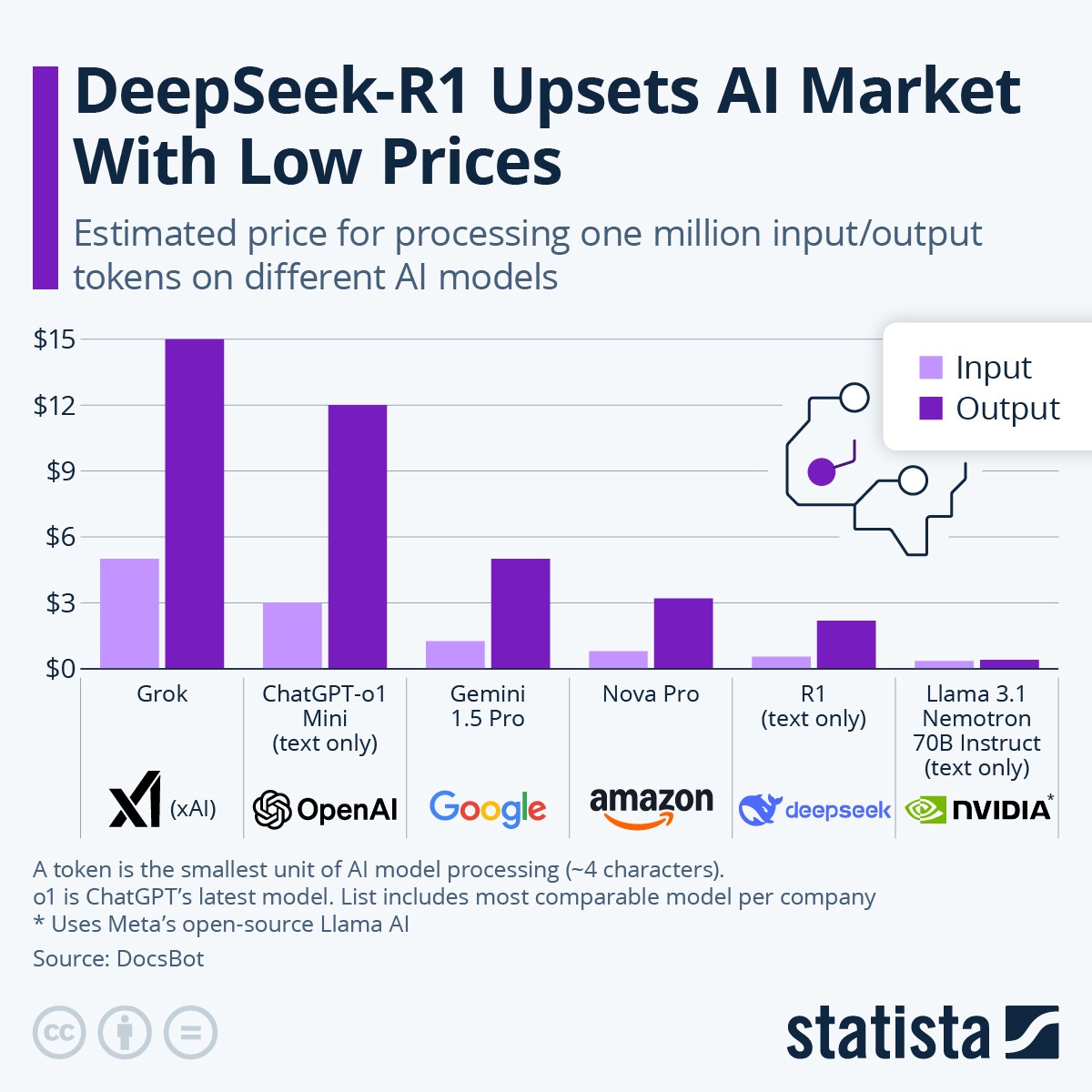

Il prezzo ridotto associato a DeepSeek-R1 è evidente anche nei dati sui costi pubblicati dal fornitore di chatbot DocsBot. Il costo commerciale dell’uso di un modello di IA viene solitamente calcolato in base ai token (la più piccola unità di elaborazione di un modello IA, pari a circa 4 caratteri). Secondo il sito di DocsBot, caricare 1 milione di token su DeepSeek-R1 costa solo 55 centesimi di dollaro, mentre scaricare 1 milione di token costa 2,19 dollari, secondo gli ultimi dati disponibili.

Il modello di IA più comparabile a R1 dell’azienda statunitense OpenAI è ChatGPT-o1 Mini, una versione ridotta del suo modello o1 più recente, progettato esclusivamente per l’elaborazione di testo (mentre la versione completa supporta sia testo che immagini). Come DeepSeek-R1, ChatGPT-o1 Mini può gestire un input di 124.000 token come contesto per una conversazione (prima di dimenticare i prompt iniziali). Tuttavia, mentre DeepSeek-R1 può generare fino a 32.000 token in una singola richiesta, ChatGPT-o1 Mini arriva a un massimo di 65.500. I punteggi ottenuti dai due programmi nei benchmark di settore – che valutano conoscenza, comprensione, capacità di ragionamento, accuratezza e coerenza – sono simili, con DeepSeek-R1 che in alcuni casi supera leggermente il suo rivale.

Il modello di IA Grok, sviluppato dalla xAI di Elon Musk, vanta una finestra di output ancora più ampia (128.000 token per richiesta) ed è in grado di elaborare sia testo che immagini. Tuttavia, nei test di benchmark, le sue prestazioni risultano leggermente inferiori rispetto a R1. Inoltre, entrambi i modelli statunitensi (ChatGPT-o1 Mini e Grok) sono molto più costosi rispetto a R1 in scenari di utilizzo commerciale, con costi di 3-5 dollari per 1 milione di token in input e 12-15 dollari per 1 milione di token in output.

Le IA di Google (Gemini) e Amazon (Nova) sono più economiche rispetto ai prodotti di OpenAI e xAI, ma comunque leggermente più costose di R1. Tuttavia, questi modelli non sono del tutto comparabili agli altri presenti nella lista, poiché sono stati sviluppati per gestire input in formati multimediali, il che li dota di finestre di input molto più grandi (ma di finestre di output più piccole – probabilmente perché progettati specificamente per funzioni di assistenza clienti e ricerca, piuttosto che per l'approccio più generalista adottato dagli altri modelli LLM). Nei test di prestazioni, anche questi modelli hanno ottenuto risultati simili a quelli di DeepSeek-R1.

Infine, un’opzione ancora più economica basata su tecnologia open-source è Llama 3.1 Nemotron 70B Instruct di Nvidia. Questo modello solo-testuale utilizza l’IA Llama di Meta e ha ricevuto valutazioni positive sia dagli utenti che nei test di prestazione.

per commentare devi effettuare il login con il tuo account